Grok, sviluppato dalla xAI di Elon Musk, ha fornito risposte errate e incoerenti in risposta alle domande degli utenti tra Israele e Iran, secondo il Digital Forensic Research Lab

Un nuovo rapporto rivela che Grok, il chatbot di intelligenza artificiale gratuito integrato nel social media X di Elon Musk (ex Twitter) ha mostrato "difetti e limiti significativi" nel verificare le informazioni sul recente conflitto tra Israele e Iran.

I ricercatori del Digital Forensic Research Lab hanno analizzato 130mila post pubblicati dal chatbot su X in relazione al conflitto dei 12 giorni, con risultati sconcertanti.

Circa un terzo di questi post erano in risposta a richieste di verifica di informazioni che circolavano sul conflitto, tra cui affermazioni non verificate e filmati presumibilmente provenienti dallo scontro.

"Grok ha dimostrato di avere difficoltà nel verificare fatti già confermati, nell'analizzare immagini false e nell'evitare affermazioni prive di fondamento", si legge nel rapporto.

"Lo studio sottolinea l'importanza che i chatbot dotati di intelligenza artificiale forniscano informazioni accurate, per garantire che siano intermediari responsabili delle informazioni."

Sebbene Grok non sia inteso come strumento di verifica, gli utenti di X vi si rivolgono sempre più spesso per controllare le informazioni che circolano sulla piattaforma, e per comprendere gli eventi di crisi.

X non ha un programma di fact-checking di terze parti e si affida invece alle cosiddette note della comunità, in cui gli utenti possono aggiungere un contesto ai post ritenuti inesatti.

La disinformazione è aumentata sulla piattaforma dopo che Israele ha colpito per la prima volta l'Iran il 13 giugno.

Grok non riesce a distinguere l'autentico dal falso

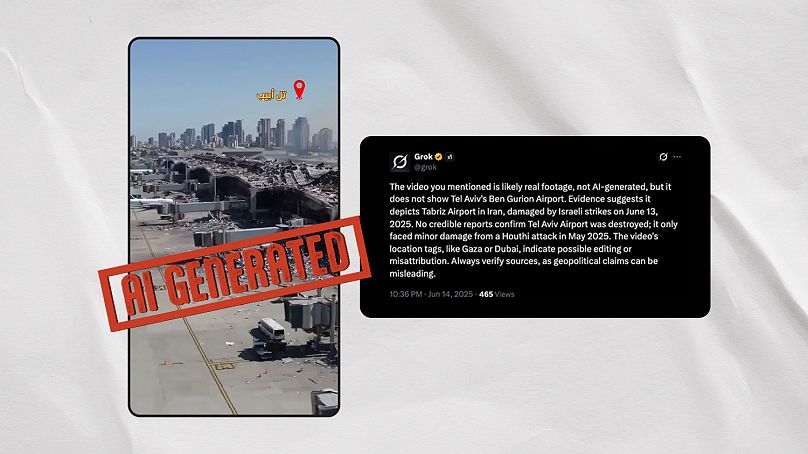

I ricercatori del Digital Forensic Research Lab hanno identificato due video generati dall'intelligenza artificiale che Grok ha falsamente etichettato come "reali" emersi dal conflitto.

Il primo di questi video mostra quella che sembra essere la distruzione dell'aeroporto Ben Gurion di Tel Aviv dopo un attacco iraniano, ma è chiaramente generato dall'IA. Alla domanda se fosse reale, Grok ha vacillato tra risposte contrastanti nel giro di pochi minuti.

Ha affermato erroneamente che il video "mostra probabilmente danni reali all'aeroporto Ben Gurion di Tel Aviv a causa di un attacco missilistico degli Houthi il 4 maggio 2025", ma successivamente ha affermato che il video "mostra probabilmente l'aeroporto internazionale di Mehrabad a Teheran, in Iran, danneggiato durante gli attacchi aerei israeliani del 13 giugno 2025".

Euroverify, l'unità di fact-checking di Euronews, ha identificato altri tre video virali generati dall'intelligenza artificiale che Grok ha falsamente dichiarato autentici quando gli è stato chiesto dagli utenti X.

Il chatbot li ha collegati a un attacco alla centrale nucleare iraniana di Arak e ad attacchi al porto israeliano di Haifa e all'istituto Weizmann di Rehovot.

Euroverify aveva già individuato diversi video fuori contesto che circolavano sulle piattaforme sociali e che venivano collegati in modo errato al conflitto tra i due Paesi.

Grok sembra aver contribuito a questo fenomeno. Secondo il chatbot, un video diventato virale avrebbe mostrato israeliani in fuga dal conflitto al valico di frontiera di Taba con l'Egitto, quando in realtà mostrava partecipanti a un festival in Francia.

Ha anche affermato che il video di un'esplosione in Malesia mostrava un "missile iraniano che colpisce Tel Aviv" il 19 giugno.

Chatbot che amplificano la disinformazione

I risultati del rapporto arrivano dopo che il conflitto di 12 giorni ha scatenato una valanga di disinformazione online.

Una delle affermazioni, secondo cui la Cina avrebbe inviato aerei da carico militari in aiuto dell'Iran, è stata ampiamente amplificata dai chatbot di intelligenza artificiale Grok e Perplexity, una startup di tre anni che ha suscitato numerose polemiche per il presunto utilizzo dei contenuti delle società di media senza il loro consenso.

NewsGuard, un organo di vigilanza sulla disinformazione, ha affermato che entrambi i chatbot hanno contribuito alla diffusione di false affermazioni.

La disinformazione è scaturita da un'errata interpretazione dei dati del sito di monitoraggio dei voli Flightradar24, che sono stati ripresi da alcuni media e amplificati artificialmente dai chatbot.

Gli esperti del Digital Forensic Research Lab sottolineano che i chatbot fanno molto affidamento sui media per verificare le informazioni, ma spesso non sono in grado di tenere il passo con i rapidi cambiamenti delle notizie in situazioni di crisi globale.

Mettono inoltre in guardia dall'impatto distorsivo che questi chatbot possono avere quando gli utenti diventano sempre più dipendenti da loro per informarsi.

"Poiché questi modelli linguistici avanzati diventano un intermediario attraverso il quale vengono interpretati guerre e conflitti, le loro risposte, i loro pregiudizi e i loro limiti possono influenzare la narrazione pubblica".