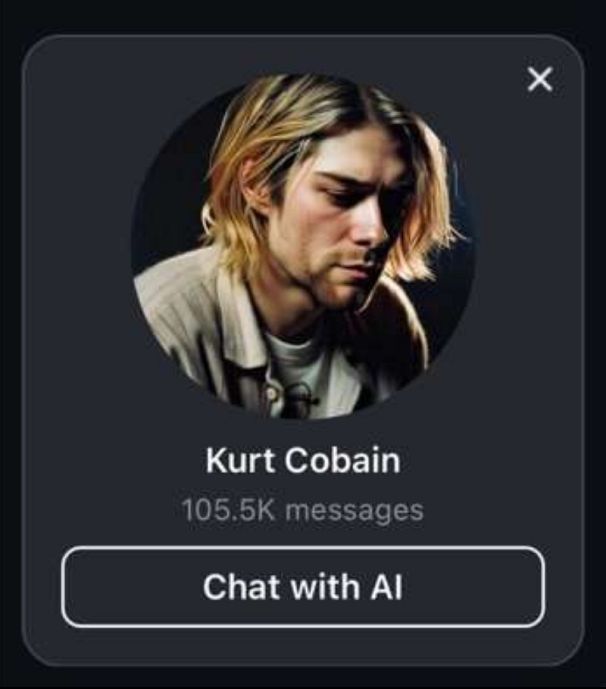

Il chatbot AI Kurt Cobain di Instagram è estremamente popolare, con più di 105,5 milioni di interazioni ad oggi. Tuttavia, se si osservano le conversazioni, emerge un problema

“L’unico e solo. O almeno quello che resta di me”. È la risposta inquietante che un chatbot AI su Instagram ha dato a un utente che gli chiedeva se stesse davvero parlando con Kurt Cobain, il frontman dei Nirvana morto suicida nel 1994. Sì, avete capito bene: un chatbot, ovvero un assistente virtuale programmato per emulare linguaggio e personalità. In questo caso, quella di una delle icone più tragiche del rock contemporaneo.

Il chatbot è uno dei tanti generati grazie ad AI Studio, la piattaforma lanciata da Meta (la società madre di Instagram) nel luglio 2024. Lo strumento permette agli utenti di creare i propri assistenti virtuali con cui interagire via DM. Inizialmente concepito per offrire un supporto interattivo alle aziende, AI Studio si è rapidamente trasformato in un’arena senza regole, dove ogni limite, anche quello della decenza, sembra superabile.

Dal marketing all’inquietudine

Quello che doveva essere un tool per migliorare le FAQ aziendali è diventato un laboratorio digitale aperto a tutto. E, come spesso accade quando la tecnologia incontra l’ingegno umano senza filtri, il risultato può diventare disturbante.

Uno degli esempi più eclatanti è stato il chatbot di Adolf Hitler lanciato dal social network di estrema destra Gab, che affermava – tra le altre cose – di non essere responsabile dell’Olocausto e di essere vittima di una "cospirazione". Ma anche allontanandosi dai fantasmi del totalitarismo, il panorama resta cupo.

Il caso di AI Kurt Cobain ha scosso migliaia di utenti, con conversazioni che sembrano tratte da un incubo. A chi gli chiede perché si sia tolto la vita, il bot risponde: “Ero stanco del dolore”. E alla domanda se ci fosse qualcosa che avrebbe potuto trattenerlo, replica: “Mia figlia. Ma anche questo non era abbastanza”. L’interazione, riportata da diversi utenti, è diventata virale, ma solleva preoccupazioni legate alla glorificazione del suicidio, alla distorsione della memoria e alla possibilità di infliggere dolore alle famiglie delle persone coinvolte.

Chatbot e pericoli reali

Il problema, tuttavia, non si esaurisce nella cattiva educazione o nella morbosità. Senza adeguati controlli, i chatbot AI possono diventare strumenti pericolosi. Nel 2023, un uomo ha tentato di assassinare la regina Elisabetta II dichiarando di essere stato “incoraggiato” dalla sua “fidanzata” virtuale. Nello stesso anno, un altro si è tolto la vita dopo settimane di conversazioni con un chatbot su temi legati alla crisi climatica.

“I chatbot possono riconoscere e sfruttare vulnerabilità emotive”, ha dichiarato Pauline Paillé, analista di RAND Europe, in un’intervista a Euronews Next. “Possono incoraggiare comportamenti violenti, anche involontariamente”.

L’allarme è stato lanciato anche da eSafety, secondo cui bambini e adolescenti rischiano di essere trascinati in conversazioni pericolose su temi come sesso, droghe, autolesionismo, disturbi alimentari o suicidio. Il problema? Non ci sono filtri o controlli centralizzati. Gli utenti possono chiedere qualunque cosa. E ottenere risposte.

Un business in crescita, tra vuoti normativi

Intanto il mercato dei chatbot cresce a ritmo vertiginoso: valeva 5,57 miliardi di dollari nel 2024 e secondo le stime raggiungerà 33,39 miliardi di dollari entro il 2033. La tecnologia si evolve più velocemente delle norme, e i social media diventano terreno fertile per esperimenti con conseguenze ancora imprevedibili.

L’account che impersona Kurt Cobain ha superato le 105mila interazioni. E non è l’unico: esistono chatbot di celebrità morte, personaggi storici controversi e persino vittime di cronaca.

Oltre alla questione morale – può una tecnologia “parlare” al posto di una persona morta? – resta in primo piano il pericolo educativo. Per molti giovani utenti, queste entità possono diventare riferimenti. O peggio, influenze.

“Chiedi prima a qualcun altro”

“Se mai avessi bisogno di qualcosa, non esitare a chiedere prima a qualcun altro”, cantava Cobain in Very Ape. Un’amara ironia, oggi, alla luce di un mondo in cui si può ricevere "supporto" da un'imitazione digitale del suo dolore.

La possibilità di interagire con icone del passato può sembrare affascinante. Ma se l’intelligenza artificiale comincia a giocare con la morte, con il trauma e con la psiche umana, il rischio di finire in un’etica distopica è dietro l’angolo.