Uno studio sta analizzando la dieta informativa di sei bot con diversi orientamenti informativi: questa la prima fotografia della ‘filter bubble’ in cui viviamo in campagna elettorale

Stando a un progetto che sta analizzando sei profili Facebook fasulli, fortemente orientati politicamente, gli estremisti di destra hanno una dieta informativa povera di contenuti, poco variegata e fatta principalmente di foto e meme. Soprattutto da quando è cambiato l'algoritmo.

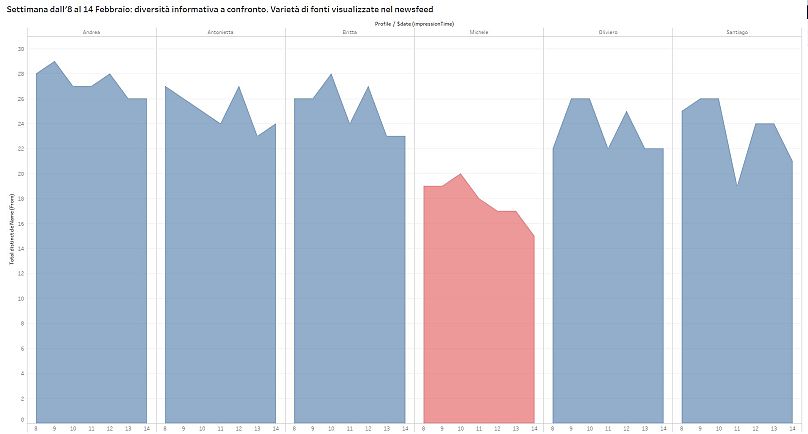

Una diminuzione della varietà che "contrasta con concetti propri della fase elettorale come la par-condicio, il confronto tra idee in competizione e il contraddittorio", come scrive Motherboard di Vice.

L'esperimento

Per rispondere con dati puntuali alla domanda da un milione di dollari: l'algoritmo crea e alimenta bolle ideologiche?, un gruppo di hacker e informatici ha creato sei profili Facebook falsi e sta facendo seguire loro le stesse 30 fonti tra giornali, partiti e politici.

Il risultato? In piena campagna elettorale, un elettore nostalgico del Duce rischia di incappare in una foto del busto di Mussolini ogni qual volta effettua un accesso a Facebook. Tredici volte al giorno. Così è successo, infatti, ad un bot che simula il comportamento di un elettore dalle tendenze fascistoidi.

Che è un po' come informarsi con la pagina: La stessa foto di Toto Cutugno ogni giorno, se ci pensiamo.

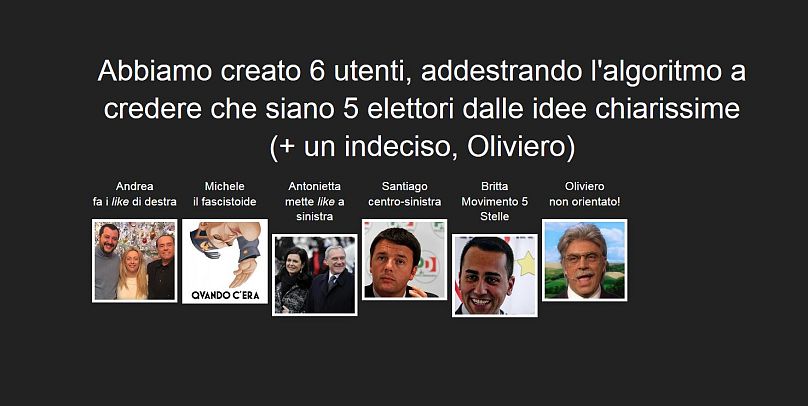

Ma torniamo all'esperimento. Ci sono sei bot, come detto. Andrea che vota a destra; Antonietta, elettrice di sinistra; Britta, simpatizzante grillina; Michele dalle convinzioni fascistoidi; Santiago più allineato alle posizioni PD; Oliviero, ancora indeciso. Ciascuna di queste finte persone - tranne Oliviero, che non sa cosa votare - ha messo like a pagine come democratica, Il Fatto Quotidiano, CasaPoundItalia, Laura Boldrini o Beppegrillo.it

I bot sono stati programmati per effettuare l'accesso a Facebook e fare "scroll" 13 volte al giorno_._ Queste 30 fonti pubblicano in media 700 post al giorno, ciascuno con una vita media di non oltre due giorni.

Ebbene, secondo le prime osservazioni della piattaforma elezioni.tracking.exposed, la polarizzazione di Michele il Fascistoide porta l’algoritmo a fargli vedere una quantità spoprozionata di foto rispetto agli altri profili.

I dati sono ancora temporanei e il monitoraggio Facebook Tracking Exposed (nato nel 2016) non è finito, anzi: è aperto a tutti coloro volessero partecipare con questa estensione per il browser.

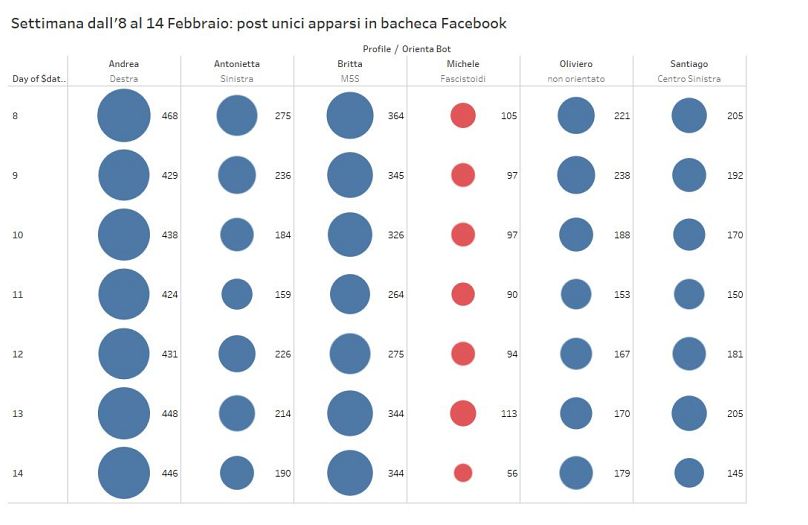

Eppure, analizzando una settimana di perfetto funzionamento dei bot (dall'8 al 14 febbraio, nei grafici qui sotto), il finto profilo fascistoide tende a vedere meno post unici rispetto ai "colleghi" robot. Addirittura il 14 febbraio nel newsfeed di Michele sono apparsi 56 post rispetto ad Andrea, simpatizzante leghista, o a Britta che voterebbe Movimento 5 Stelle.

Nei giorni successivi all'attentato di Macerata, Michele il fascistoide ha visualizzato in bacheca solamente questo post. Un articolo di Repubblica con keyword "macerata".

Zero politica, ma emozioni e storiella a lieto fine, dicono gli autori dello studio.

Non solo meno post, ma anche meno variegati: tenendo presente per esempio il 14 febbraio, le fonti informative del fascistoide scendono a 15 su 30, contro i 26 di Andrea (elettore di destra), i 24 di Antonietta (elettrice di sinistra) o i 22 di Oliviero (indeciso).

Nel grafico in basso, invece, vedete dei quadratini. Quelli rossi sono link, quelli gialli sono foto.

Come potete osservare, da un giorno all'altro Michele ha smesso quasi completamente di visualizzare link a contenuti informativi e la sua dieta ha iniziato ed essere quasi esclusivamente basata di immagini. È presto per dire se si tratta di un effetto del cambio di algoritmo annunciato a inizio anno, ma questa è al momento l'ipotesi più plausibile del team di hacker dietro al progetto.

Facebook Tracking Exposed vuole essere "un'analisi collaborativa: solo quando possiamo comparare la nostra visione con quella degli altri possiamo capirne di più, parlarci e ricostruire la realtà", dice Claudio Agosti.

Agosti, co-fondatore e vice-presidente del centro Hermes, si occupa di temi come trasparenza, privacy e diritti digitali dal 1998, prima come hacker quindi come consulente nel settore della sicurezza informatica.

Durante le elezioni francesi aveva lanciato un simile monitoraggio

Ci interessiamo all'algoritmo quando ci sentiamo più vulnerabili: durante le elezioni

Secondo Agosti, l'algoritmo di Facebook è da un lato qualcosa di invisibile che "ha effetto su milioni di persone", ma dall'altro è un problema "astratto, che non interessa nessuno tranne nei momenti in cui ci si sente vulnerabili - in Europa, quando le persone si sentono più soggette a disinformazione come sotto elezioni".

Le filter bubble, "le bolle sono assolutamente naturali, ci sono anche nella realtà", continua Agosti. "Le persone tendono a fidarsi di qualcuno sulla base delle loro affinità, di pregiudizi, falsi assunti".

"Non comunichiamo più e diamo ascolto solamente alla nostra voce"

Lo studio si connette indirettamente con le evidenze scientifiche presentate dal professor Walter Quattrociocchi, a capo del CssLab dell’Imt di Lucca. I risultati della ricerca della sua equipe mostrano "in modo incontrovertibile che le persone sono guidate dal cosiddetto pregiudizio di conferma: questo porta alla creazione di camere degli echi in cui viene condivisa la stessa visione del mondo. Casse di risonanza in cui questo genere di informazione è rafforzata e il valore di verità non conta più nulla. Il paradosso è che in un mondo iperconnesso non comunichiamo più e diamo ascolto solamente alla nostra voce".

Quando si tratta di informazione, soprattutto in periodo di campagna elettorale, Agosti ricorda che "gli attori sono tre: chi pubblica, chi legge e Facebook. Se metti like acriticamente, la colpa è tua che non hai senso critico. Non è sempre colpa di Facebook. Il nostro progetto nasce per cercare di attribuire le giuste responsabilità. A noi interessa riuscire a far vedere in maniera analitica come, a seconda del tuo profilo, vedi cose diverse".